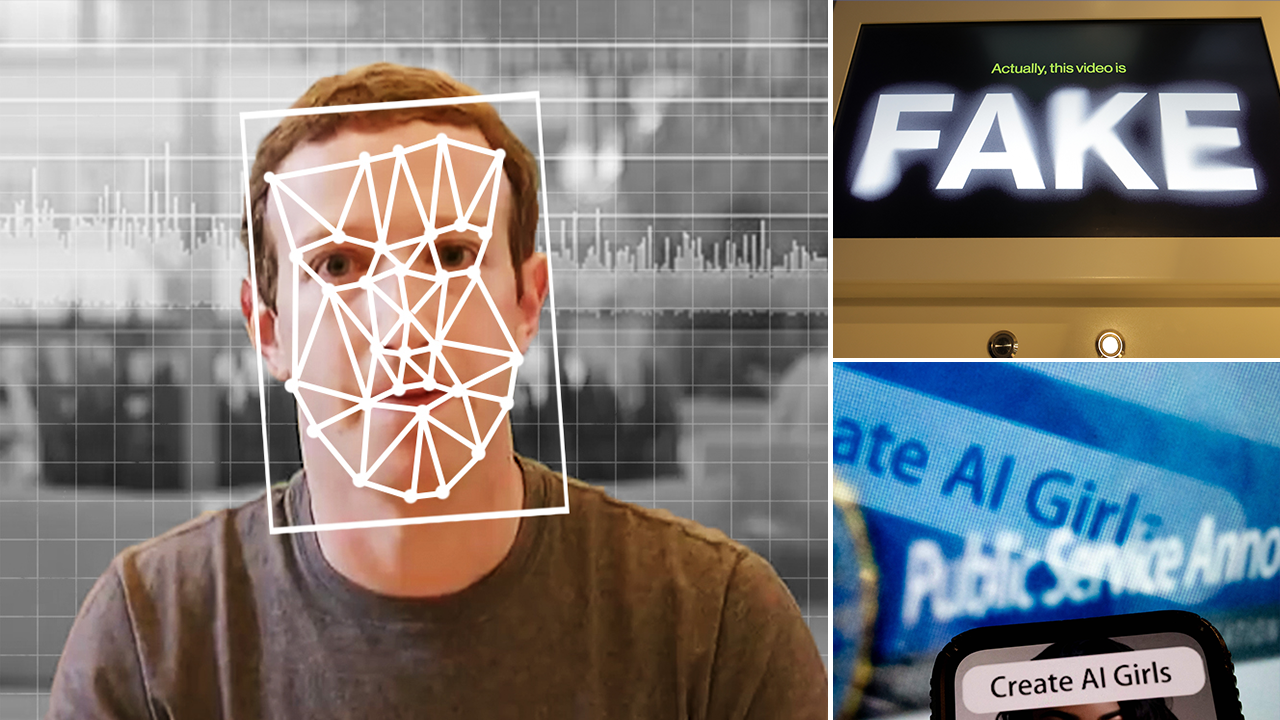

L’intelligence artificielle (IA) produit des «jumeaux numériques» hyperréalistes de politiciens, de célébrités, de matériel pornographique, et plus encore – laissant les victimes de la technologie profonde du mal à déterminer le recours juridique.

L’ancien agent de la CIA et expert en cybersécurité, le Dr Eric Cole, a déclaré à Fox News Digital que les mauvaises pratiques de confidentialité en ligne et la volonté des gens de publier leurs informations publiquement sur les réseaux sociaux les rend sensibles aux profondeurs de l’IA.

“Le chat est déjà sorti du sac”, a-t-il déclaré.

“Ils ont nos photos, ils connaissent nos enfants, ils connaissent notre famille. Ils savent où nous vivons. Et maintenant, avec l’IA, ils sont capables de prendre toutes ces données sur qui nous sommes, à quoi nous ressemblons, ce que nous faisons et comment nous agissons, et essentiellement en mesure de créer un jumeau numérique”, a poursuivi Cole.

Gardez ces conseils à l’esprit pour éviter d’être dupés par Deepfakes générés par l’AI-AI

Les images générées par l’AI, appelées «profonds», impliquent souvent l’édition de vidéos ou de photos de personnes pour les faire ressembler à quelqu’un d’autre ou utiliser leur voix pour faire des déclarations qu’ils n’ont jamais prononcés dans la réalité. (Elyse Samuels / The Washington Post / Lane Turner / The Boston Globe / Stefani Reynolds / AFP via Getty Images)

Ce jumeau numérique, a-t-il affirmé, est si bon qu’il est difficile de faire la différence entre la version artificielle et la vraie personne sur laquelle la profondeur est basée.

Le mois dernier, un clip audio frauduleux a circulé par Donald Trump Jr. suggérant que les États-Unis auraient dû envoyer du matériel militaire en Russie au lieu de l’Ukraine.

Le poste a été largement discuté sur les réseaux sociaux et semblait être un clip d’un épisode du podcast “déclenché avec Donald Trump Jr.”

Les experts de l’analyse numérique ont confirmé plus tard que l’enregistrement de la voix de Trump Jr. a été créé à l’aide de l’IA, notant que la technologie est devenue plus «compétente et sophistiquée».

FactPostNews, un récit officiel du Parti démocrate, a publié l’audio comme s’il était authentique. Le compte a ensuite supprimé l’enregistrement. Un autre compte, républicains contre Trump, a également publié le clip.

Au cours des dernières années, de nombreux exemples d’IA Deepfakes ont été utilisés pour induire les téléspectateurs induits en erreur avec le contenu politique. Une vidéo de 2022 a montré ce qui semblait être le président ukrainien Volodymyr Zelenskyy se rendant à la Russie – mais le faux clip a été mal fabriqué et seulement brièvement répandu en ligne.

Des vidéos manipulées du président Donald Trump et de l’ancien président Joe Biden ont par la suite paru dans la perspective de l’élection présidentielle américaine de 2024. Sur la base des vidéos existantes, ces clips ont souvent modifié les paroles ou les comportements de Trump et Biden.

Le porno généré par l’AI, y compris les faux nus de célébrités, persiste sur Etsy alors que les lois Deepfake «sont à la traîne»

Une femme à Washington, DC, considère une vidéo manipulée le 24 janvier 2019, qui change ce qui est dit par le président Donald Trump et l’ancien président Barack Obama, illustrant comment la technologie profonde a évolué. (Rob Lever / AFP via Getty Images)

Les images générées par l’AI, appelées «Deepfakes», impliquent souvent l’édition de vidéos ou de photos de personnes pour les faire ressembler à quelqu’un d’autre en utilisant l’IA. Deepfakes a frappé le radar du public en 2017 après qu’un utilisateur de Reddit ait publié une pornographie réaliste des célébrités sur la plate-forme, ouvrant les vannes aux utilisateurs employant une IA pour rendre les images plus convaincantes et leur permettant d’être plus largement partagées au cours des années suivantes.

Cole a déclaré à Fox News Digital que les gens sont leur “pire ennemi” concernant l’IA Deepfakes, et limiter l’exposition en ligne peut être le meilleur moyen d’éviter de devenir victime.

Cependant, dans la politique et les médias, où “la visibilité est la clé”, les personnalités publiques deviennent une cible principale pour l’utilisation néfaste de l’IA. Un acteur de menace intéressé à reproduire le président Trump aura beaucoup de fourrage pour créer un jumeau numérique, siphonnant les données du leader américain dans différents contextes.

Le Congrès doit arrêter un nouvel outil d’IA utilisé pour exploiter les enfants

“Plus je peux me procurer une vidéo, comment il marche, comment il parle, comment il se comporte, je peux alimenter cela dans le modèle d’IA et je peux faire dufake Deep aussi réaliste que le président Trump. Et c’est là que les choses deviennent vraiment, vraiment effrayantes”, a ajouté Cole.

En plus d’assumer la responsabilité personnelle du décalage des données personnelles en ligne, Cole a déclaré que la législation pourrait être une autre méthode pour réduire la mauvaise utilisation de l’IA.

Sens. Ted Cruz, R-Texas et Amy Klobuchar, D-Minn., Ont récemment introduit le Take It Down Act, ce qui en ferait un crime fédéral pour publier ou menacer de publier des images intimes non consensuelles, y compris des «contrefaçons numériques» conçues par l’intelligence artificielle. Le projet de loi a adopté à l’unanimité le Sénat plus tôt en 2025, avec Cruz au début de mars, il pensait qu’il sera adopté par la Chambre avant de devenir loi.

La première dame Melania Trump s’est rendue lundi à Capitol Hill pour une table ronde pour se rassembler pour le ACT à retirer. (Fox News)

La législation proposée nécessiterait des sanctions pouvant aller jusqu’à trois ans de prison pour partager des images intimes non consensuelles – authentiques ou générées par l’AI – impliquant des mineurs et deux ans de prison pour les images impliquant des adultes. Il faudrait également des sanctions pouvant aller jusqu’à deux ans et demi de prison pour des infractions à la menace impliquant des mineurs, et un an et demi de prison pour des menaces impliquant des adultes.

Le projet de loi nécessiterait également des sociétés de médias sociaux tels que Snapchat, Tiktok, Instagram et des plateformes similaires pour mettre en place des procédures pour supprimer ce contenu dans les 48 heures suivant l’avis de la victime.

Élèves du secondaire, les parents ont mis en garde contre la menace de photo nue profonde

La première dame Melania Trump a parlé à Capitol Hill plus tôt ce mois-ci depuis son retour à la Maison Blanche, participant à une table ronde avec les législateurs et les victimes du porno de vengeance et des fesses profondes générées par l’AI.

“Je suis ici avec vous aujourd’hui avec un objectif commun – de protéger nos jeunes contre les dommages en ligne”, a déclaré Melania Trump le 3 mars. “La présence généralisée d’un comportement abusif dans le domaine numérique affecte la vie quotidienne de nos enfants, de nos familles et de nos communautés.”

Andy Locascio, cofondatrice et architecte d’Eternos.Life (crédité de la construction du premier jumeau numérique), a déclaré que si la loi “Retirez” est une “évidence”, il est complètement irréaliste de supposer qu’il sera efficace. Il note qu’une grande partie de l’industrie de l’IA Deepfake est servie à partir d’emplacements non soumis à la loi américaine, et la législation n’aurait probablement qu’un impact sur une infime fraction de sites Web incriminés.

L’expert en sécurité nationale Paul Scharre considère une vidéo manipulée de Buzzfeed avec le cinéaste Jordan Peele (R à l’écran) en utilisant des logiciels et des applications facilement disponibles pour changer ce qui est dit par l’ancien président Barack Obama (L à l’écran), illustrant comment la technologie DeepFake peut tromper les téléspectateurs, dans ses bureaux de Washington, DC, le 25 janvier 2019. (Rob Lever / AFP via Getty Images)

Il a également noté que la technologie de clonage de texte vocale peut désormais créer des «contrefaçons parfaites». Alors que la plupart des principaux fournisseurs ont des contrôles importants en place pour empêcher la création de contrefaçons, Locascio a déclaré à Fox News Digital que certains fournisseurs commerciaux étaient facilement dupés.

En outre, Locascio a déclaré que toute personne ayant accès à une unité de processeur graphique (GPU) raisonnablement puissante pourrait construire ses propres modèles vocaux capables de prendre en charge des «clones». Certains services disponibles nécessitent moins de 60 secondes d’audio pour produire cela. Ce clip peut ensuite être modifié avec un logiciel de base pour le rendre encore plus convaincant.

Le sénateur démocrate ciblé par Deepfake Imitersonor of Ukrainian Official on Zoom Call: Rapports

“Le paradigme concernant le réalisme de l’audio et de la vidéo a changé. Maintenant, tout le monde doit supposer que ce qu’ils voient et entendant sont faux jusqu’à ce qu’ils soient authentiques”, a-t-il déclaré à Fox News Digital.

Bien qu’il y ait peu de directives pénales concernant l’IA Deepfakes, l’avocat Danny Karon a déclaré que les victimes présumées peuvent encore poursuivre les réclamations civiles et recevoir des dommages-intérêts en fonds.

Dans son prochain livre “Votre adorable avocat Guide du bien-être juridique: lutter contre un monde qui est là pour vous tromper”, Karon note que l’IA Deepfakes relève de la loi de diffamation traditionnelle, en particulier la diffamation, qui implique de diffuser une fausse déclaration via la littérature (écriture, images, audio et vidéo).

Cette photo d’illustration prise le 30 janvier 2023 montre un écran de téléphone affichant une déclaration du chef de la politique de sécurité à Meta avec une fausse vidéo (R) du président ukrainien Volodymyr Zelensky appelant ses soldats à déposer leurs armes montrées en arrière-plan, à Washington, DC (Olivier Douliery / AFP via Getty Images)

Pour prouver la diffamation, un demandeur doit fournir des preuves et des arguments sur des éléments spécifiques qui répondent à la définition juridique de la diffamation conformément à la loi de l’État. De nombreux États ont des normes similaires pour prouver la diffamation.

Par exemple, en vertu de la loi de Virginie, comme ce fut le cas dans le procès Depp c. Entendu, l’équipe de l’acteur Johnny Depp a dû satisfaire les éléments suivants qui constituent une diffamation:

- Le défendeur a fait ou publié la déclaration

- La déclaration concernait le demandeur

- La déclaration a eu une implication diffamatoire pour le demandeur

- L’implication diffamatoire a été conçue et prévue par le défendeur

- En raison des circonstances entourant la publication, il pourrait incuber une implication diffamatoire à quelqu’un qui l’a vu

“Vous ne pouvez pas conclure que quelque chose est en diffamation jusqu’à ce que vous sachiez ce qu’est la loi et la diffamation. Amber a entendu, par exemple, ne l’a pas fait, c’est pourquoi elle ne pensait pas qu’elle faisait quoi que ce soit de mal. Il s’avère qu’elle l’était. Elle a intervenu et elle a payé tout cet argent. C’est l’analyse que les gens doivent traverser pour éviter les ennuis car cela concernait des fesseurs profonds ou disant des choses en ligne”, a déclaré Karon.

Karon a déclaré à Fox News Digital que les affirmations de l’IA Deepfake peuvent également être canalisées par l’invasion du droit de la vie privée, le droit d’intrusion, le harcèlement civil et le droit à la publicité.

Le juge fédéral bloque la loi de Californie interdire les élections profondes

L’image hyper-réaliste de Bruce Willis est en fait un Fake Deep créé par une entreprise russe utilisant des réseaux de neurones artificiels. (Deepcake via Reuters)

“Si Tom Hanks a fait coopter sa voix récemment pour promouvoir un plan dentaire, c’est un exemple d’une entreprise exploitant le nom, l’image et la ressemblance de quelqu’un, et dans ce cas, pour vendre un produit, promouvoir ou pour dériver de la publicité de quelqu’un d’autre. Vous ne pouvez pas le faire”, a-t-il déclaré.

Malheureusement, des problèmes peuvent survenir si un demandeur n’est pas en mesure de déterminer qui a créé lefake Deep ou si l’agresseur est situé dans un autre pays. Dans ce contexte, une personne qui cherche à poursuivre un cas de diffamation peut devoir embaucher un expert Web pour trouver la source du contenu.

Si l’individu ou l’entité est international, cela devient un problème de lieu. Même si une personne est trouvée, un demandeur doit déterminer la réponse à ces questions:

- L’individu peut-il être servi?

- La nation étrangère aidera-t-elle à faciliter cela?

- Le défendeur se présentera-t-il au procès?

- Le demandeur a-t-il une probabilité raisonnable de collecter de l’argent?

Si la réponse à certaines de ces questions est non, investir le temps et les finances nécessaires pour poursuivre cette réclamation peut ne pas en valoir la peine.

“Nos droits ne sont aussi efficaces que notre capacité à les appliquer, comme un brevet. Les gens disent:” J’ai un brevet, donc je suis protégé. ” Non, vous ne le faites pas.

Cliquez ici pour obtenir l’application Fox News

Brooke Singman et Emma Colton de Fox News ont contribué à ce rapport.